Robots.txt ファイルを作成するためのクイック ガイド

膨大な教科書をどうやって参照するのですか? インデックスをふるいにかけます。 そうですね: ウェブサイトの本当の要約となる要素が XNUMX つあります…

検索エンジンのスパイダーや クローラー、というファイルを介して行われます robots.txtの. またはそれ以上。 ウェブサイトの提案を Google に送信すると、膨大な量の情報に直面します。

必要なものがすべて見つからないと感じるほど膨大な量の教科書をどのように調べますか? 相談する インデックス. さて、robots.txt ファイルはウェブサイトのインデックスです。

これは、検索エンジンのクローラーに何を探すべきかを伝える、入力しやすいドキュメントです。 要するに、あなたのサイトが何で構成されているかを彼が理解するのを助けて、アルゴリズムがあなたが行った仕事に適したランキングをあなたに与えることができるようにする.

誰でも robots.txt ファイルを作成できますか?

短い答えはイエスです。 正直な答えはノーです。 robots.txt ファイルの文法は非常に単純で、その構成は数行で構成されていますが、どこに手を置くべきかを知っている専門のウェブマスターの世話に頼ることをお勧めします。 結局のところ、小さなミスが Web サイトのポジショニングを損なうのに十分であり、そのためすべての SEO 操作が開始前に停止してしまいます。

開始する前に、XNUMX つのことを知っておいてください。 ドメインの後に /robots.txt を書くことで、誰でも任意のサイトの robots.txt ファイルを調べることができます. Google に相談することもできます。

特別なソフトウェアをダウンロードしなくても、このようなファイルを書き込むことができます。 実際、メモ帳を使用して .txt 形式で保存するだけで十分です。

robots.txt を一緒に書きましょう: ヘッダー

常に論理的であるため、最初から始めましょう。 ファイルを開く部分、つまりヘッダー部分は、スパイダーの名前専用で、その前に常に同じ小さな文言が続きます。 Google に注目してもらいたいとしましょう。 したがって、最初の行は次のようになります。

User-agent:Googlebot

この非常に短い文字列は、Google がこれ以降に続くすべての内容に関心があることを示しています。 このタイプのファイルを読み取るすべてのクローラーがドキュメントを参照できるようにする場合は、単純な * を Googlebot に置き換えます。 アスタリスク.

どのスパイダー、つまり WHO を指定したので、指定する必要があります。 また、彼が読まなければならないもの.

コードの各行は、定義上、マシンのアクションに対応しています。 言うまでもなく、robots.txt ファイル内の各コマンドは、マシンが実行してはならないことに対応しています。 そして、これは本当に効果的なものを書くことを可能にする鍵です. DISALLOW コマンドについて話しています。

DISALLOW コマンドとは何ですか?

Il コマンドを許可しない 除外によって推論することができます。 つまり、やってはいけないことを先に言うというのは、まぁ、除外による理屈ですよね。 不許可に加えて、ブロックの例外である許可もあります。

優れた robots ファイルを作成したい場合は、逆に考える必要があるため、読み取ってはいけないものを Google に伝える必要があります。 あなたが書く場合:

許可しません:

スパイダーは、ブレーキをかけずにサイト全体を読み取ります。

「Disallow:」の後にスラッシュを挿入すると (したがって、Disallow: /)、そのサイトは検索エンジンに入力されなくなります。

許可しない: /directories/

ディレクトリという単語を、スパイダー ビューから拒否するフォルダーに置き換えます。 特定のファイルでも同じことができます。

許可しない: /myfile.html

への注意 句読点と文字、大文字または小文字。 このタイプのファイルは、この種の「ささいなこと」を高く評価していますが、大きな違いがあります。

Google がサイトの大部分を読み取らないようにする理由は何ですか? このタイプのファイルを作成するときは、どのファイルが検索エンジンに表示されるべきではないかを理解することが重要ですが、それらを悪用することはありません。 ただし、その特定のファイルの正確なアドレスを知っている人は誰でもアクセスできることに注意してください。

ALLOW コマンドとは何ですか?

ファイルでは、コマンドで例外を追加できます 許可する. 文法は同じですが、DISALLOW に対していくつかの例外が作成され、スパイダーの探索の興味深いマージンが開かれます。

小さなサンプル ファイル:

User-agent:Googlebot

許可しない: /images/

許可: /images/holidays.jpg

基本的に、私たちは Googlebot に画像フォルダを考慮しないように指示しました。ただし、その中の特定の写真、つまり休暇中の写真を除きます。

それで、みんな、それだけです。 最初の robots.txt ファイルを作成しました。 確かに、実際のサイトで行うことは多少異なる場合がありますが、それほど大きくはありません。 疑問がある場合は、常に専門のウェブマスターからアドバイスを受けてください。 基本をマスターし、サイトの仕組みをよりよく理解するために、まず自分で書いてみて、チェックのために彼に送ることをお勧めします。

robots.txt とサイトマップの相関関係は?

サイトマップは、サイト上のすべてのリンクを含む特別なプラグインによって生成されるファイルです。 スパイダーがサイトに入ると、まずロボットを読み取り、次にサイトをクロールします。 クロール中にロボットがサイトマップ アドレスを見つけた場合、プロセス全体がはるかに簡単になります。

上記のコードに次を追加します。

サイトマップ: http://www.ilnomedeltuositobellissimo.com/sitemap.xml

結論として

すべてのロボット ファイルは同じです。 これは、Google 用に作成された Robots ファイルが Bing でも問題なく機能し、同じ文法に従うことを意味します。

robots.txt ファイルを整理すると、次のことが可能になります。 クローラーの時間を節約. がっかりしないでください: これは成功への第一歩です!

あなたも興味があるかもしれません:

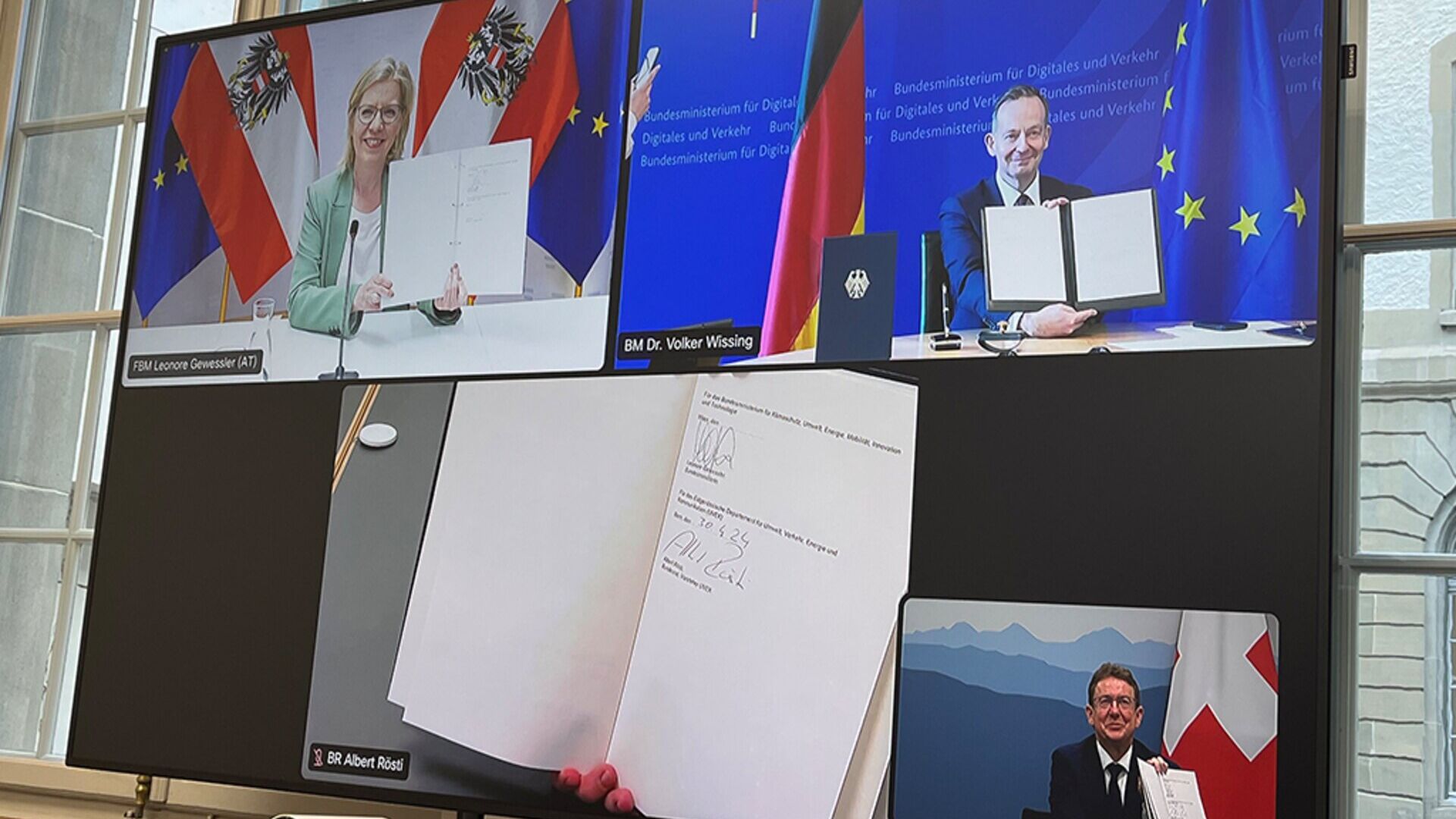

オーストリア、ドイツ、スイスが「より革新的な」貨物鉄道を目指す

DACH大臣のレオノーレ・ゲヴェスラー氏、フォルカー・ヴィシング氏、アルベルト・ロスティ氏:デジタル自動ペアリングの導入は重要な要素である

若者と暗号通貨: ビットコインについてもっと知るには…

子どもたちにデジタル通貨やブロックチェーンを紹介することは、子どもたちのテクノロジーやイノベーションへの親近性を考えると、刺激的な取り組みになる可能性があります。

「患者が中心」:大きな希望と上院での会合

ヨーロッパの医療における医療機器のイノベーションの重要性というテーマが、15月XNUMX日にローマで専門家と政治家によって検討される予定

アルベルト・ニコリーニdistrictbiomedicale.it、BioMed News、Radio Pico の編集者